文章摘要

在使用GPU服务器训练TensorFlow模型时,由于默认显存占用问题,模型难以完成训练。为了解决这一问题,可以按照以下方法进行调整:

1. **设置显存占用**

在代码开头加入以下内容:

```python

import os

os.environ["CUDA_VISIBLE_DEVICES"] = "0" # 或者其他GPU编号

```

该代码仅使用指定的GPU。

2. **调整显存分配比例**

使用`tf.GPUOptions`设置显存使用比例,例如:

```python

gpu_options = tf.GPUOptions(per_process_gpu_memory_fraction=0.333)

```

0.333表示每个GPU进程使用显存上限的1/3。

3. **动态分配内存**

使用`tf.config`设置动态显存分配:

```python

config = tf.ConfigProto(gpu_options=gpu_options)

config.gpu_options.allow_growth = True

```

`allow_growth=True`表示按需分配显存。

这些方法可以帮助合理分配显存资源,避免显存占用问题,同时确保模型能够顺利训练。

目录Tensorflow训练模型默认占满所有GPU问题TensorFlow默认的是占用所有GPU解决tensorflow2.2把GPU显存占满解决代码总结

在使用gpu服务器训练tensorflow模型时,总是占满显存!

因此我们需要手动设置使用的GPU编号以及单个GPU显存占用比例

1.第一步需要在代码中开头加入

import os

os.environ[“CUDA_DEVICE_ORDER”]=”PCI_BUS_ID” # 按照PCI_BUS_ID顺序从0开始排列GPU设备

os.environ[“CUDA_VISIBLE_DEVICES”]=‘0′ ?# 使用0号gpu(想使用其他编号GPU,对应修改引号中的内容即可)

os.environ[“CUDA_VISIBLE_DEVICES”]=‘0,1′ # 使用0号GPU和1号GPU

os.environ[“CUDA_DEVICE_ORDER”]=”PCI_BUS_ID” # 按照PCI_BUS_ID顺序从0开始排列GPU设备

os.environ[“CUDA_VISIBLE_DEVICES”]=‘0′ ?# 使用0号gpu(想使用其他编号GPU,对应修改引号中的内容即可)

os.environ[“CUDA_VISIBLE_DEVICES”]=‘0,1′ # 使用0号GPU和1号GPU

2.第二步需要将代码中的sess=tf.Session()改为

gpu_options=tf.GPUOptions(per_process_gpu_memory_fraction=0.333) # 通过改变0.333可以改变占用显存比例

sess=tf.Session(config=tf.ConfigProto(gpu_options=gpu_options))

sess=tf.Session(config=tf.ConfigProto(gpu_options=gpu_options))

per_process_gpu_memory_fraction=0.333代表的含义就是每个GPU进程中使用显存的上限为该GPU总量的1/3

3.如果想要在程序运行过程中连续查看GPU信息

可以在终端使用该 指令(执行指令:watch -n 3 -d nvidia-smi # 每隔三秒输出一次)(前提是设备中有合适的NVIDIA驱动)

安装了tensorflow-gpu后,运行程序默认是把GPU的内存全部占满的,有时我们不想全部占满,可以这样操作。

import tensorflow as tf

import os

os.environ[‘CUDA_VISIBLE_DEVICES’]=”0″ # 指定哪块GPU训练

config=tf.compat.v1.ConfigProto()

# 设置最大占有GPU不超过显存的80%(可选)

# config.gpu_options.per_process_gpu_memory_fraction=0.8

config.gpu_options.allow_growth=True # 设置动态分配GPU内存

sess=tf.compat.v1.Session(config=config)

import os

os.environ[‘CUDA_VISIBLE_DEVICES’]=”0″ # 指定哪块GPU训练

config=tf.compat.v1.ConfigProto()

# 设置最大占有GPU不超过显存的80%(可选)

# config.gpu_options.per_process_gpu_memory_fraction=0.8

config.gpu_options.allow_growth=True # 设置动态分配GPU内存

sess=tf.compat.v1.Session(config=config)

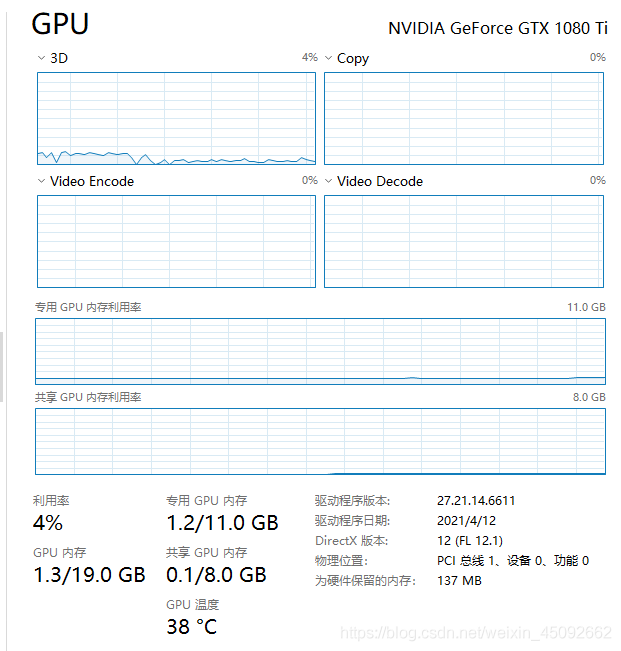

如图:

以上为个人经验,希望能给大家一个参考,也希望大家多多支持脚本之家。

您可能感兴趣的文章:解决tensorflow训练时内存持续增加并占满的问题Tensorflow自定义模型与训练超详细讲解解决Tensorflow占用GPU显存问题

© 版权声明

文章版权归作者所有,未经允许请勿转载。